破解海量网络安全大数据存储难题 六步构建高效数据处理与存储支持体系

随着数字化转型的加速,网络安全领域产生的数据呈指数级增长,日志、流量记录、威胁情报等海量信息对传统存储架构构成了严峻挑战。为破解这一难题,我们通过系统性规划与实践,构建了一套高效的数据处理与存储支持服务体系,其核心可归纳为以下六个关键步骤。

第一步:需求分析与架构设计

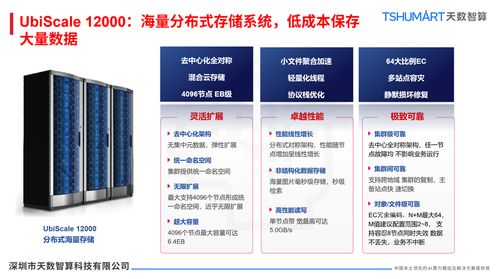

首要任务是明确业务需求与技术指标。我们深入分析安全数据的类型(如结构化日志、非结构化网络包)、数据量增长预测、读写性能要求、合规保存期限及实时查询需求。基于此,设计分层存储架构,将热数据(高频访问)置于高性能存储(如全闪存阵列),温数据置于大容量混合存储,冷数据(归档)迁移至成本更低的对象存储或磁带库,实现成本与性能的最优平衡。

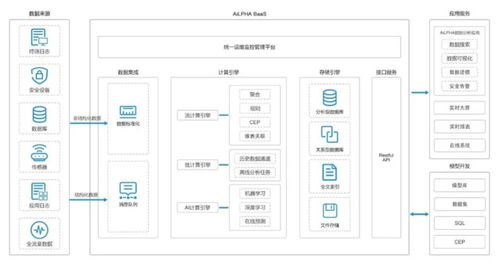

第二步:数据标准化与预处理

原始安全数据格式杂乱,直接存储效率低下。我们建立了统一的数据标准化管道,对来自防火墙、IDS/IPS、终端防护等不同源头的数据进行解析、清洗、归一化(如统一时间戳、IP格式、事件类型编码),并提取关键特征。通过流处理技术(如Apache Kafka + Flink)进行实时预处理,过滤噪音,仅将高价值信息存入核心存储,大幅降低无效存储开销。

第三步:分布式存储系统部署

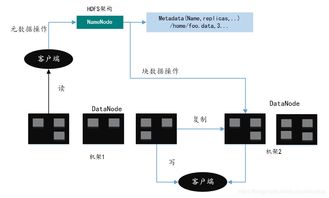

为满足海量数据扩展性与高可用性,我们摒弃了传统集中式存储,部署了横向扩展的分布式存储系统。采用HDFS、Ceph或云原生对象存储服务,构建可线性扩容的存储池。通过数据分片与多副本机制(通常3副本),确保数据持久性与跨节点负载均衡,即使单节点故障也不影响服务,同时支持PB级容量平滑扩展。

第四步:高效索引与元数据管理

快速检索是安全分析的关键。我们在存储层之上构建了多级索引体系:对时间、源IP、事件类型等常见查询字段建立分布式索引(如使用Elasticsearch);维护全局元数据目录,记录数据位置、格式、压缩状态及生命周期标签。结合列式存储格式(如Parquet)优化扫描性能,使千亿级记录下的关联查询响应时间从小时级降至秒级。

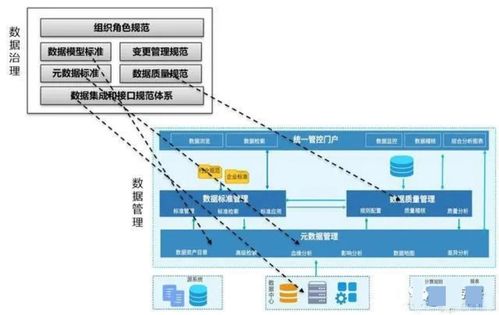

第五步:生命周期与自动化治理

制定精细化的数据生命周期策略。通过策略引擎自动执行数据流转:例如,将30天内的热数据保留在高性能层,30-90天的温数据转存至标准存储,超过1年的冷数据压缩后归档。实施自动化数据去重、压缩(采用Snappy、Zstandard等算法)与加密,存储效率提升超60%,并确保敏感数据全程合规加密。

第六步:监控、容灾与持续优化

建立全面的存储健康监控体系,实时跟踪容量使用率、IOPS、延迟及错误率。设置智能预警,在容量达到阈值前自动触发扩容。构建跨地域或跨云容灾方案,通过异步复制实现数据备份与快速恢复。定期基于实际访问模式调整存储策略,例如利用机器学习预测热点数据,动态调整数据布局,实现系统性能的持续优化。

通过这六步闭环实践,我们成功构建了弹性、高效、可靠的安全大数据存储基础。该体系不仅化解了海量数据存储的物理瓶颈,更通过智能数据处理赋能上层威胁分析、事件调查与态势感知,真正将数据负担转化为安全防御的战略资产。我们将持续探索存储计算分离、存算一体等新技术,以应对日益演进的安全数据挑战。

如若转载,请注明出处:http://www.quickagrade.com/product/57.html

更新时间:2026-02-25 10:14:18